在构建 AI 系统时,你可能遇到这种问题:

用户发起一个问题 → 大模型回答 → 用户追问 → AI 完全不记得之前说了什么?

这时,就需要引入一个「大脑管家」:MCP(Model Context Protocol),它让多轮对话、工具调用和上下文管理变得井井有条。

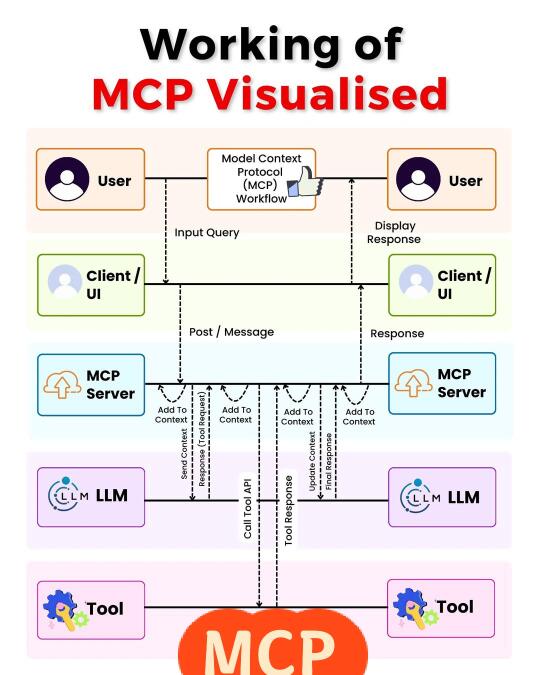

下面我们用一张图,拆解 MCP 是怎么让整个系统“有记忆”“能行动”的:

⸻

MCP 工作流程分解:

1. 用户发起输入(Input Query)

比如:“查下明天纽约的天气。”

2. 客户端 UI 发送请求 → MCP Server 接收

MCP Server 像一个调度中心,记录当前上下文,并准备将请求交给大模型处理。

3. MCP Server 发送上下文给 LLM(大语言模型)

MCP 会“告诉”模型用户之前说过什么、当前意图是什么。

4. LLM 分析后调用 Tool API(比如天气查询工具)

如果需要用外部工具,大模型就会发起调用请求(如 REST API)。

5. Tool 返回结果 → LLM 获取并更新上下文

比如:“纽约明天小雨,气温 15℃”,这个结果被加进对话上下文中。

6. MCP Server 记录结果上下文 → 返回 UI → 展示给用户

最终用户看到的回答,不仅准确,还“记得之前说过的话”。

为什么 MCP 重要?

• 多轮对话保持连贯(不会“失忆”)

• 工具调用有上下文追踪(知道“为什么调用”)

• 系统每一环都清晰、有记录、有上下文补全

—

MCP 本质上不是模型,而是一种 “上下文驱动的流程协议”,是未来所有 Agent 系统、AI 助理都绕不开的核心设计。