HBM不是内存,是AI的命脉。

一块芯片,堆了16层内存,带宽直接干到1.35TB/s。

这哪是升级,是给AI大脑装了火箭推进器。

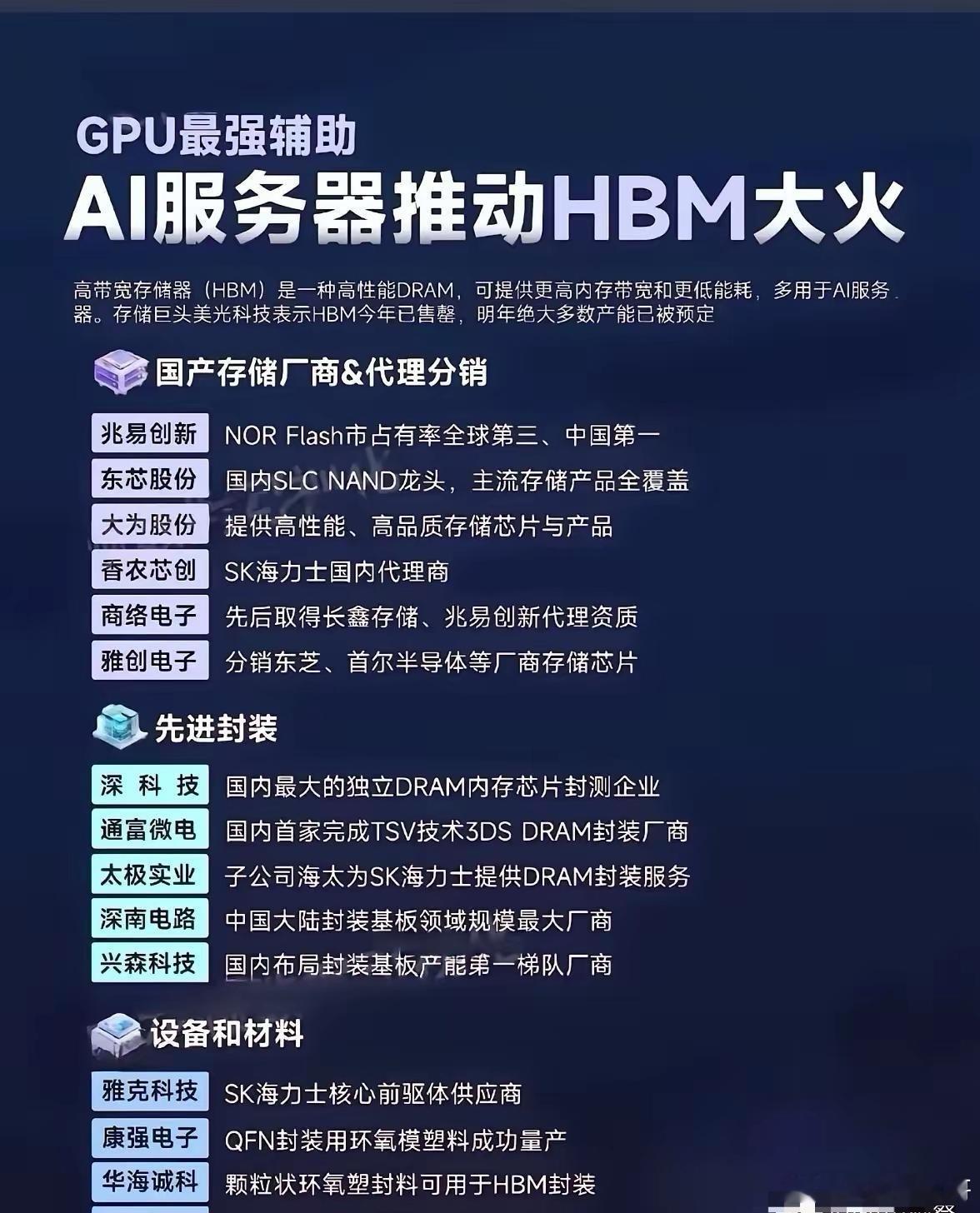

SK海力士先发制人,三星紧咬不放,美光靠省电杀进NVIDIA供应链。

中国也亮了底牌——长江存储国产8层HBM,没用老路子,直接跳到混合键合,一步到位。

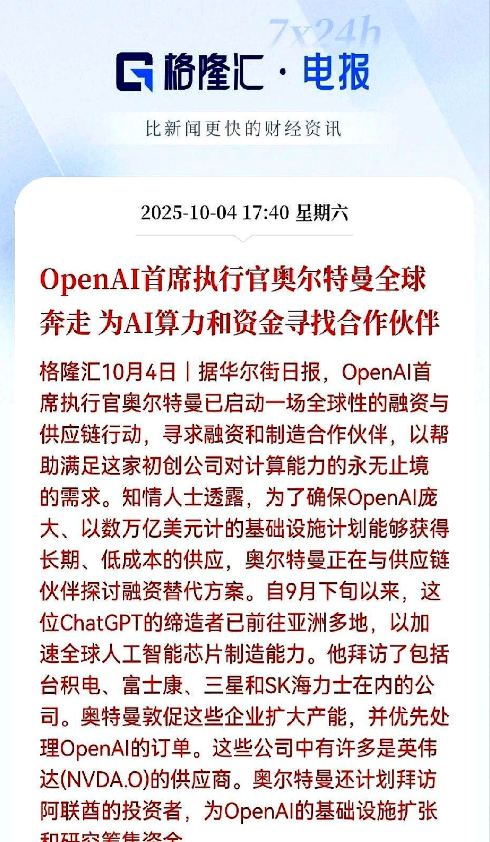

AI模型越来越大,OpenAI新模型单卡要144GB HBM,一个月跑完,内存带宽够烧掉一个中型电厂。

台积电说,2026年,每5块DRAM,就有1块是给AI专用的。

可你猜怎么着?

产能追不上。

TSV封装厂全在韩国和台湾,交货周期拉到8个月。

不是芯片不够强,是它太强了,没人能跟上它的节奏。

散热更头疼。16层堆起来,热得像火锅底料。

三星和美光给芯片戴上“微流道冰帽”,硬是把温度压下去。

这哪是造内存,这是在刀尖上跳舞。

HBM的战场,不在价格,不在容量,而在谁能先让这栋摩天大楼稳稳立住,不塌、不烫、不掉链子。