Mamba核心作者新作新注意力机制速度超越DeepSeek

推理提速2倍还省内存?Mamba作者又整新活了。

Tri Dao团队刚发布两种专为推理设计的注意力机制:Grouped-Tied Attention(GTA)和Grouped Latent Attention(GLA)。它们在不牺牲模型生成质量的前提下,显著提升了解码速度和内存利用率,尤其适合长上下文场景。

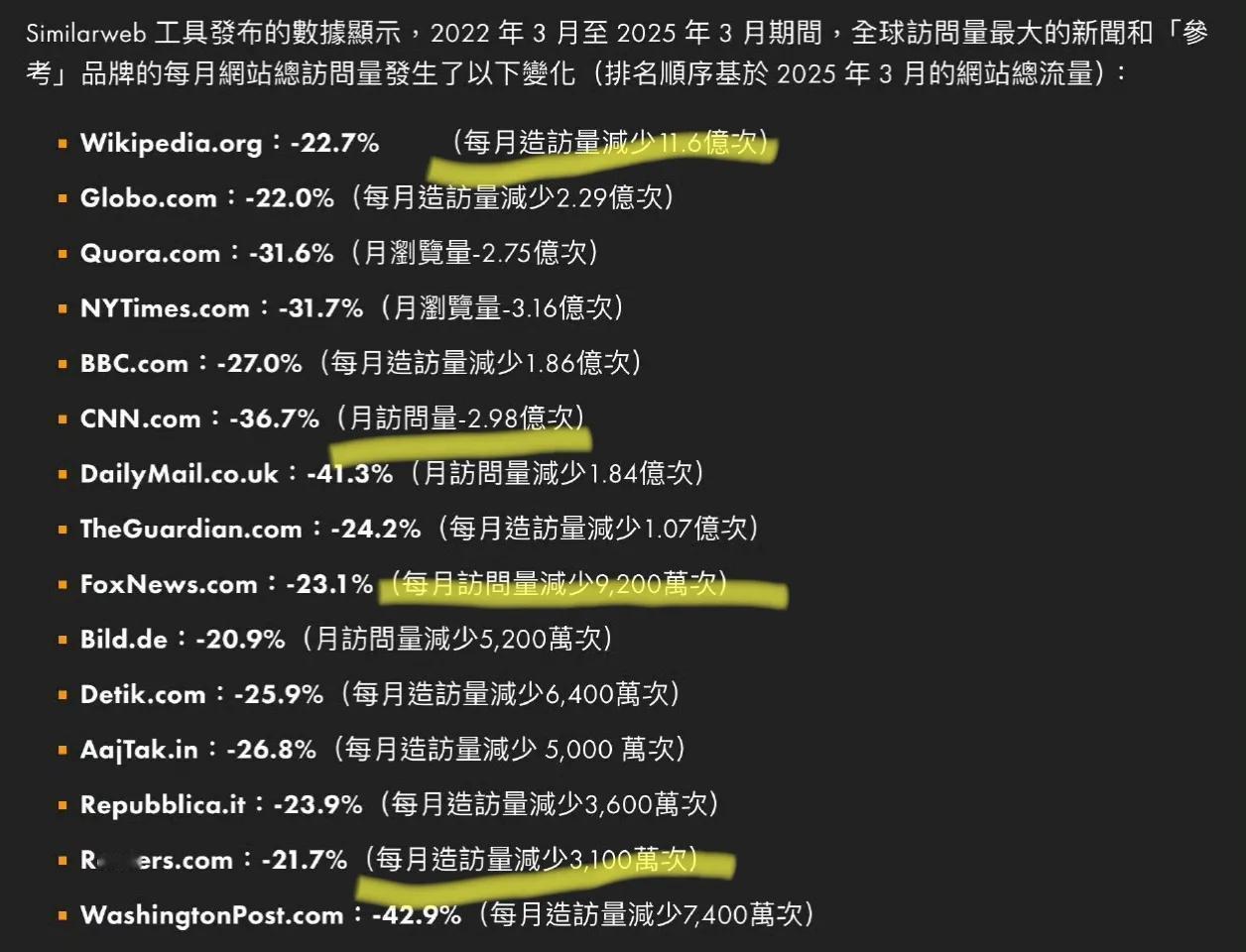

团队在四种模型规模上测试了GTA和GLA,指标涵盖质量(困惑度、7个下游任务)与效率(解码延迟、吞吐量、KV缓存量)。结果显示:

- GTA在中大型模型中质量优于GQA;

- GLA与MLA在精度上相当,但效率更高;

- GLA在预填充长度32K、64K时的吞吐量明显领先;

- 并发处理能力也更强,能更好应对长文本和不均衡负载。

![DeepSeek的低调升级远超预期给你们总结一下[doge]1.代码生成质量](http://image.uczzd.cn/11995075565103573833.jpg?id=0)