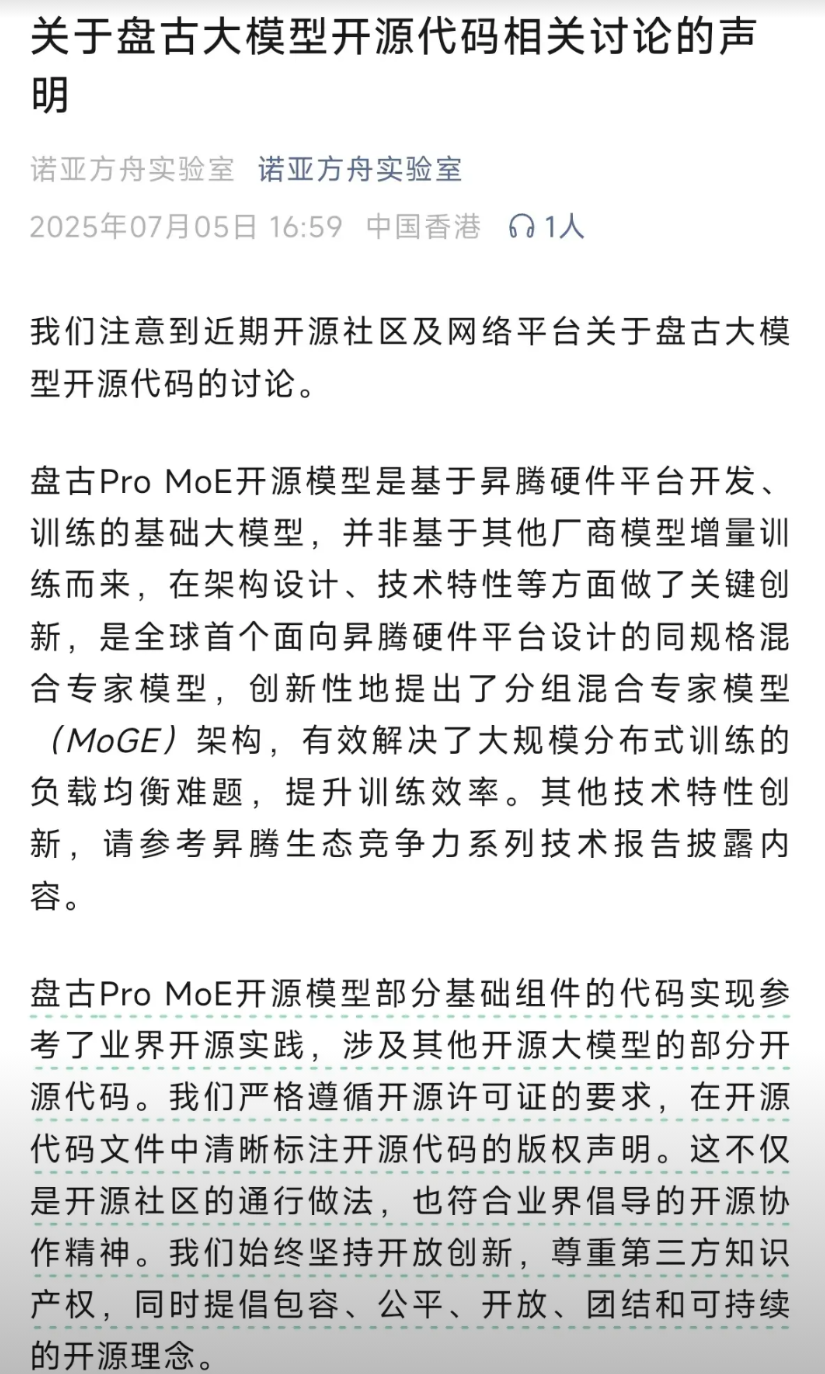

【[20星]transformers-qwen3-moe-fused:优化Qwen3 MoE模型,让其在单GPU上高效运行。亮点:1. 针对Qwen3-30B-A3B优化,适配24GB显存;2. 兼容HF Transformers生态,支持LoRA、4位量化;3. 提供示例代码,方便快速上手】

"Qwen3 MoE Fused: Optimized for single GPU training with high throughput"

GitHub: github.com/woct0rdho/transformers-qwen3-moe-fused

机器学习 深度学习 模型优化 人工智能 ai兴趣创作计划

![AI都想不出来的旗帜,被他们给想出来了[滑稽笑]](http://image.uczzd.cn/17545383058090581910.jpg?id=0)