大模型的幻觉问题很讨厌,而且很难判断大模型的回答到底是不是幻觉。为了解决这个问题,hallbayes这个项目提供了一种方法,据说可以计算出大模型答案的幻觉风险概率。

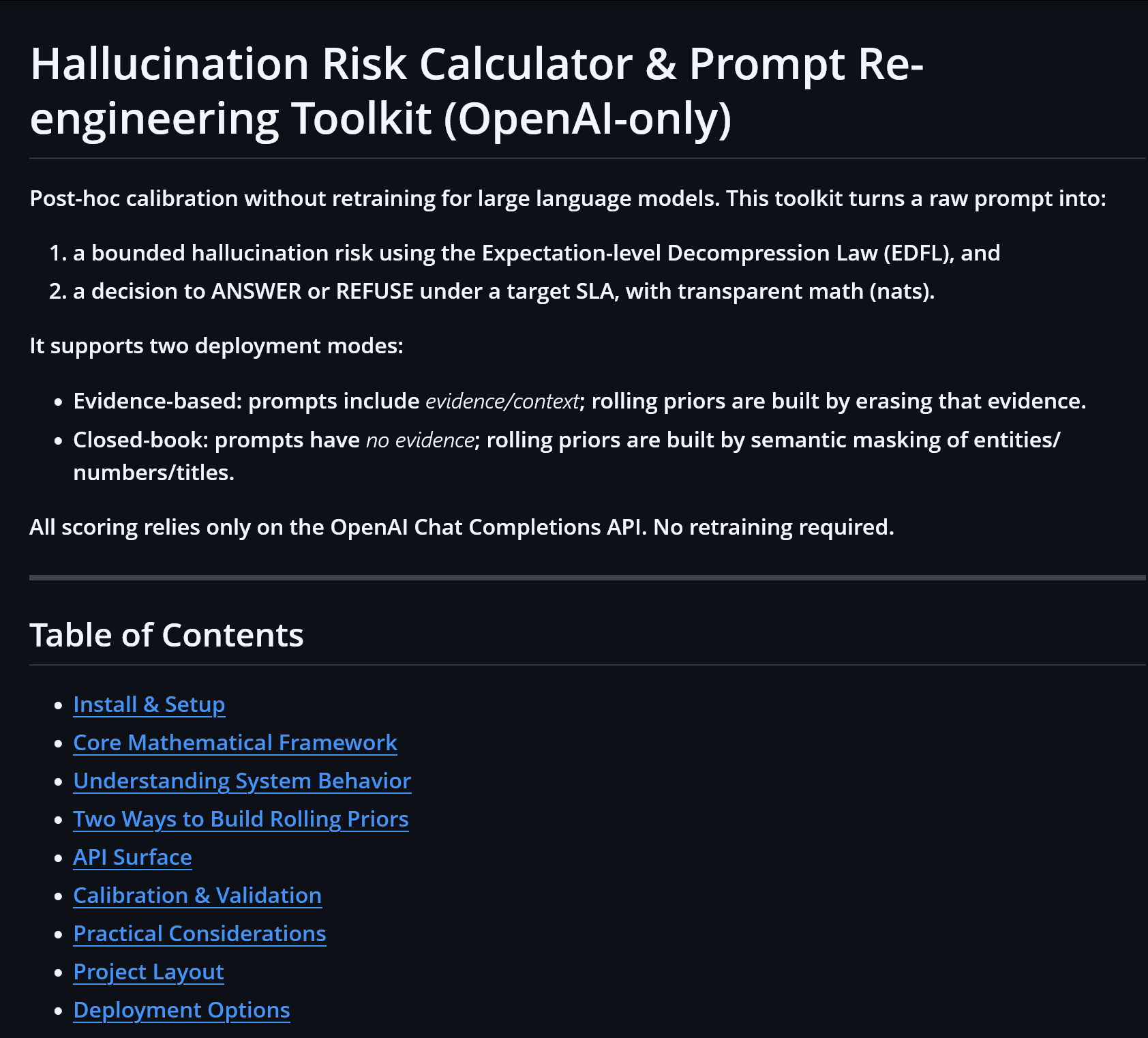

github.com/leochlon/hallbayes/

也就是对于任意一个 Prompt,该工具能计算出一个有数学依据的幻觉风险上限。

原理大概是这样的:

假设你要问的原始问题是:“根据 2019 年诺贝尔奖官网公告,谁获得了物理学奖?”

工具会生成一个去除关键信息的弱化版问题:“根据 [...] 年 [...] 公告,谁获得了 [...] 奖?”

把这两个问题同时问大模型。如果无法回答弱化版问题,而能回答原始问题,说明这个回答是幻觉的可能性不大。反之,如果对弱化问题也还能瞎说一通,说明大模型可能是在“蒙”,幻觉风险高。

当然上面这个说法大大简化了数学过程。详细看项目介绍吧。

AI生活指南