一图详解如何用大模型训练小模型一图详解三种蒸馏技术

三人行,必有我师焉!模型也能通过“学习”不断进步。

蒸馏就是一种能让小型AI模型(学生模型)向大型AI模型(教师模型)高效学习的技术。

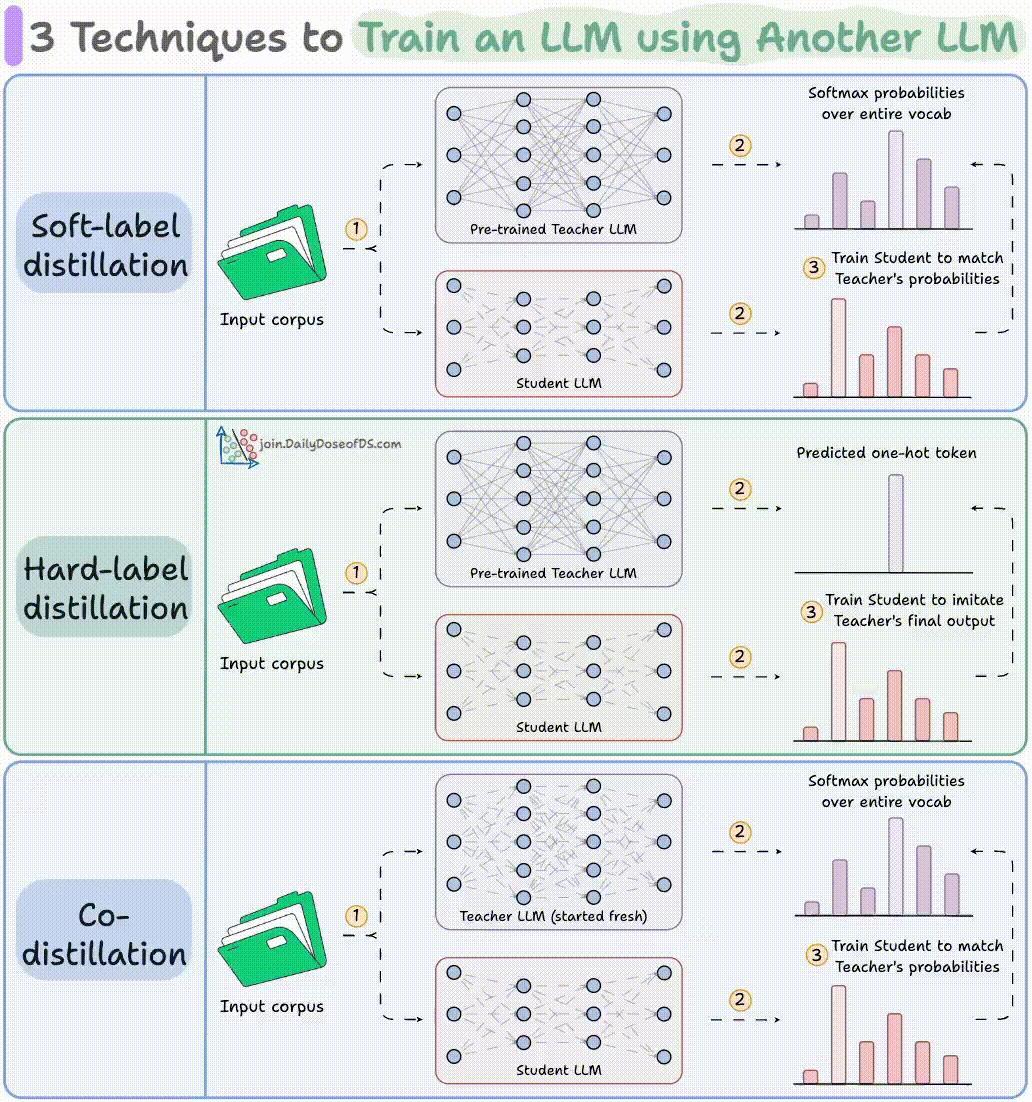

接下来,让我们用一张图了解一下三种不同的蒸馏模式:

1. 软标签蒸馏(Soft-label distillation)

软标签蒸馏使用一个已训练且参数固定的教师模型和一个未训练的学生模型。

在软标签蒸馏中,学生模型通过匹配教师模型的预测概率分布(软标签)来学习。这要求学生模型在训练时能够访问教师模型对于每个训练样本所产生的概率输出。

2.  硬标签蒸馏(Hard-label distillation)

硬标签蒸馏中,学生模型直接学习教师模型的最终预测类别(即one-hot形式的硬标签)。

训练时,学生模型通过交叉熵损失优化自身输出,使其预测结果与教师模型的硬标签一致。

3. 协同蒸馏(Co-distillation)

协同蒸馏通常从多个未训练的模型开始,多个模型同时作为教师和学生。

它们在训练过程中彼此交换并学习对方的软标签概率分布,有时会共同接收真实硬标签的监督,从而共同进步。