英伟达近期披露的 VLA 架构模型 Alpamayo-R1,其实针对的是自动驾驶量产的核心瓶颈,按吴新宙的表述,该模型与英伟达 Thor 车规平台搭配后,预计未来几年将在 GTC 大会上官宣落地奔驰、Lucid 及 Stellantis 的部分车型。

不同于单纯的技术探索,Alpamayo-R1 直指当前自动驾驶落地的三大痛点,以 “数据 - 训练 - 架构” 的全链路优化,给出了兼顾性能与量产可行性的答案。

其实目前辅助驾驶在常规路况已趋成熟,但真正制约落地的,是三个绕不开的 “老大难” 问题:

(一)传统端到端 “怕罕见场景”

依赖模仿学习的端到端模型,只会复刻见过的驾驶行为,遇到 “暴雨 + 施工 + 行人横穿” 这类长尾极端场景就容易失效 —— 本质是 “只会模仿,不会推理”,缺乏对未知风险的因果判断能力。

(二)推理与动作 “两张皮”

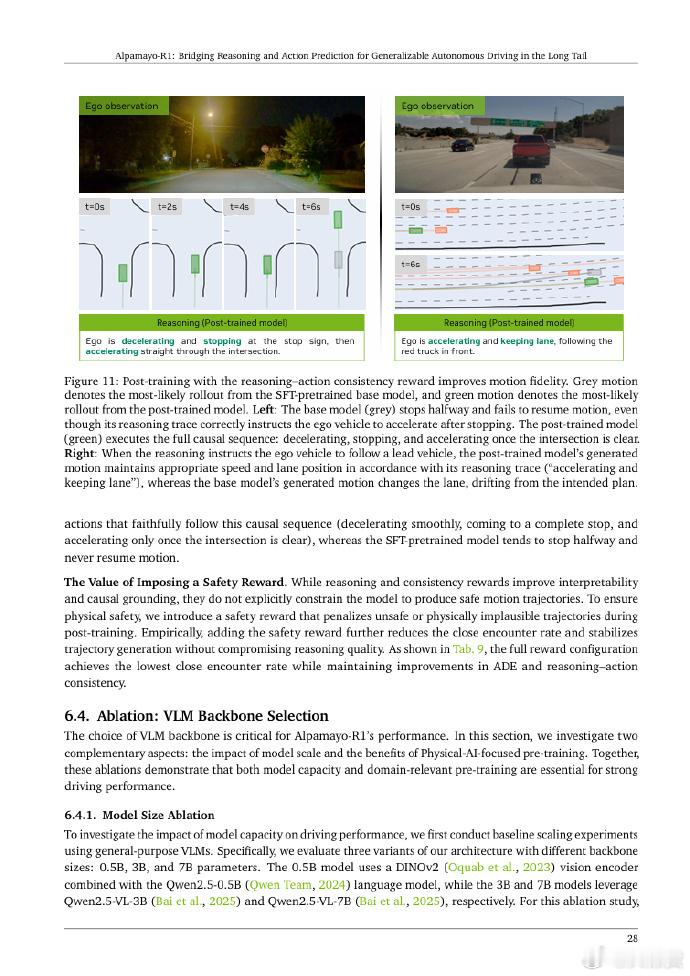

不少 VLA 用户有共鸣:中控屏上 VLM 输出的 “思维链”(如 “需减速避施工车”)看似合理,但车辆实际操作却偏差明显。这是因为 VLM 的文字推理与控车模型的动作规划完全脱节,推理沦为 “纸上谈兵”,无法转化为实际驾驶行为。

(三)参数与实时性 “难平衡”

自动驾驶要求延迟控制在 100 毫秒内,但模型参数量少则决策精度不足,参数量提升(如从 0.5B 到 7B)又会加重计算负担,导致延迟超标,成为量产适配的核心阻碍。

✅ 痛点 1 解法:CoC 因果链数据集,让模型 “懂因果”

为解决极端场景推理弱的问题,Alpamayo-R1 首次提出因果链(Chain of Causation, CoC)数据集,每条数据都标注 “场景原因 - 驾驶决策” 的完整逻辑(如 “右侧施工车占道→需减速左变道”),让模型不仅知 “行”,更知 “为何行”。为兼顾规模与质量,英伟达采用 “人工 + GPT-5 自动标注 + 质量审计” 模式:AI 批量标注后,人工修正偏差(如剔除 “引用未来场景” 的错误标注),最终形成大规模高质量训练数据,通过 SFT 让模型掌握驾驶因果逻辑。

✅ 痛点 2 解法:可验证奖励机制,打通 “推理 - 动作” 闭环

借鉴 OpenAI o1、DeepSeek-R1 的思路,Alpamayo-R1 设计可验证奖励机制:强化学习阶段同步评估 “推理文本” 与 “实际动作”,若推理(如 “减速避让”)与动作一致则给奖励,反之则惩罚。这一步让 “推理 - 动作一致性” 提升 37%,彻底终结 “说一套做一套” 的问题。

✅ 痛点 3 解法:高效视觉编码,实现 “大参数 + 低延迟”

通过重新设计 Vision Encoder,Alpamayo-R1 将视觉输入 token 数量压缩 10-20 倍(如单图 token 从 160 降至 8),配合优化计算逻辑,最终实现两大突破:参数量从 0.5B 提升至 7B(轨迹准确性提升 11%),端到端延迟却控制在 99 毫秒 —— 刚好满足车端实时性要求,破解 “精度与延迟” 的矛盾。

从 Alpamayo-R1 的技术选择,能清晰看到英伟达的量产布局:CoC 数据集的混合标注模式控制成本,视觉编码适配 Thor 平台算力,再结合英伟达 DGX 训练、Omniverse 仿真的全栈能力,Alpamayo-R1 正成为连接 “技术研发” 与 “车型落地” 的核心纽带。

【个人看法】红仔觉得这一思路对国产 AD 亦有借鉴意义:当前不少团队陷入 “参数竞赛”,而 Alpamayo-R1 的核心是 “回归基本功”—— 解决极端场景推理、推理动作对齐这些真痛点。未来自动驾驶落地,或许更需要这种 “问题导向” 的技术突破,而非单纯的功能堆砌。大v聊车