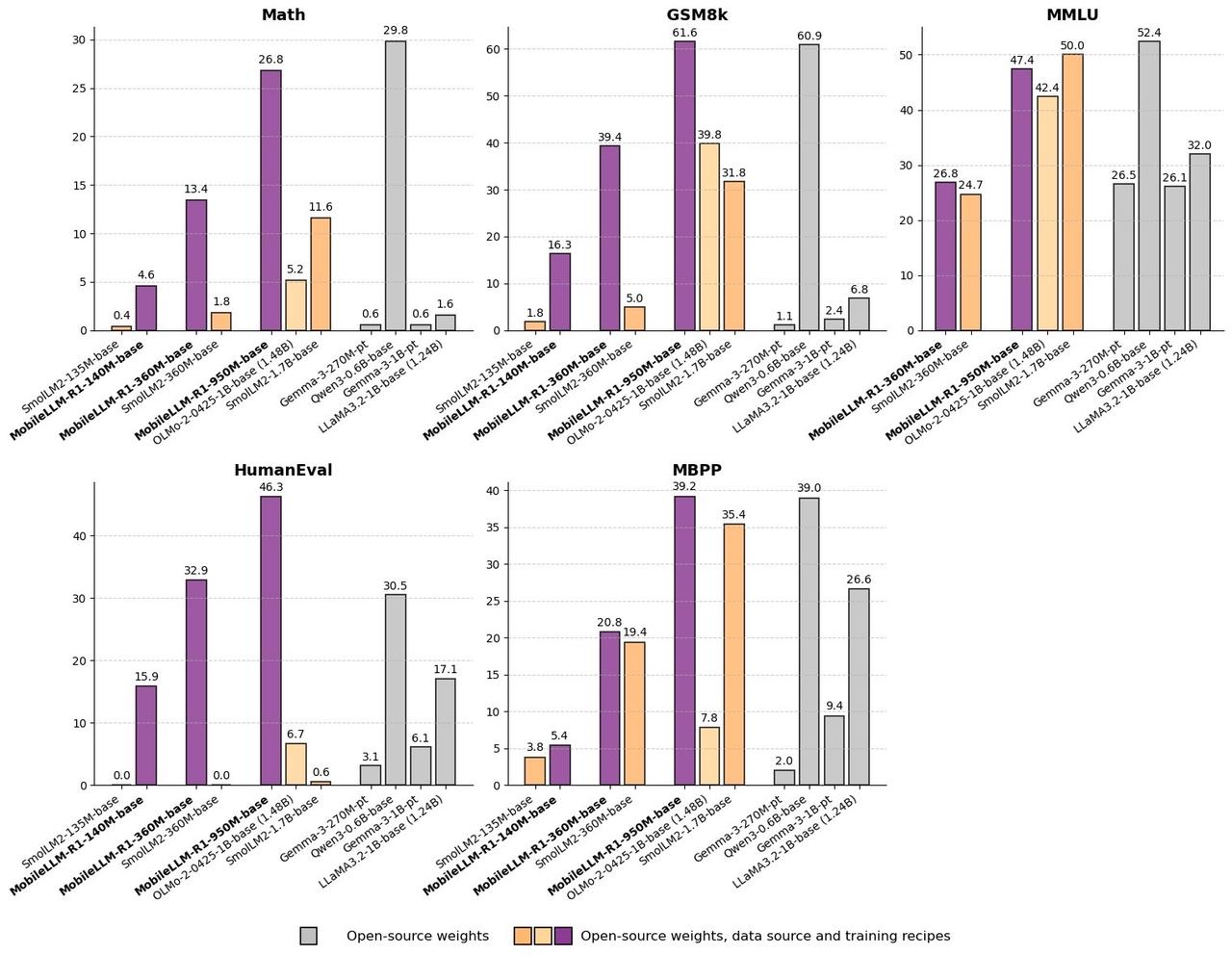

Meta 刚刚在 Hugging Face 上发布了 MobileLLM-R1 边缘推理模型,参数少于 10 亿 性能提升 2–5×,超越其他完全开源模型:MobileLLM-R1 MATH 准确率上比 Olmo-1.B 高约 5 倍,比 SmolLM2-1.7B 高约 2 倍。 与 Qwen 相比,仅使用 1/10 的预训练 token:仅用 4.2 万亿 token(仅占 Qwen3 的 36 万亿 token 的 11.7%)进行训练,就在多个推理基准测试中达到或超过 Qwen3 的准确率。 每天跟我涨知识 深度学习 日常生活 技术分享