大语言模型可以从互联网上海量的文本中学习,但当这些模型需要进化成能够自主行动的智能体(Agent)时,数据问题变得完全不同。Agent 需要的不是简单的文本序列,而是包含“观察-行动-反馈”完整循环的交互轨迹(trajectory)数据。

相关研究显示,这类数据的收集正成为 Agent 开发的最大瓶颈:人工标注成本高昂,合成数据质量难以保证,而记录现有 Agent 的轨迹又受限于其能力上限。

虽然已有一些自我进化(self-evolution)方法试图让模型自己生成训练数据,但这些方法普遍面临两个困境:模型只能生成不超出自身知识范围的任务,以及仅支持单轮交互而无法处理复杂的多步推理。

面对这个困境,近期,由北卡罗来纳大学教堂山分校(UNC)助理教授姚骅修领导的联合团队提出了 Agent0 框架,试图通过引入外部工具和多轮交互来打破这些局限。

图丨相关论文(来源:arXiv)

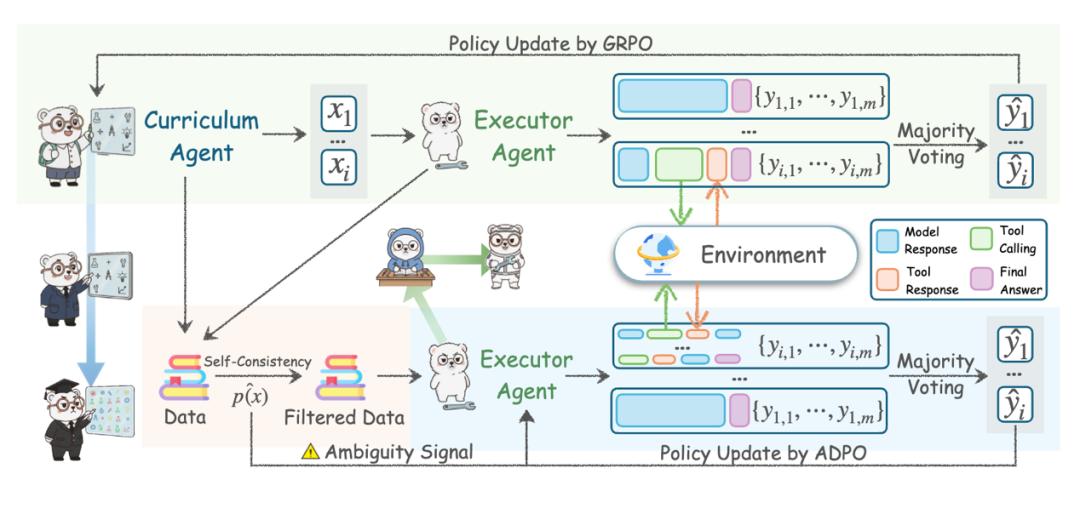

Agent0 的核心是一个双智能体协同进化系统。系统包含两个从同一基础模型初始化的 Agent:课程智能体(Curriculum Agent)负责生成问题,执行智能体(Executor Agent)则尝试解决这些问题。

但课程智能体不是随意出题,而是通过强化学习(Reinforcement Learning,RL)优化,专门生成那些恰好处于执行智能体能力边界的任务。

这个边界如何界定?研究团队用了一个巧妙的方法:让执行智能体对同一问题生成多个答案,如果答案不一致,说明这个问题正好在它能力的边缘。

他们将这种不确定性量化为一个奖励函数,当执行智能体的答案分布接近 50% 一致时,也就是最纠结的时候,奖励最高。这种设计确保了生成的任务既不会太简单让模型学不到东西,也不会难到完全无法入手。

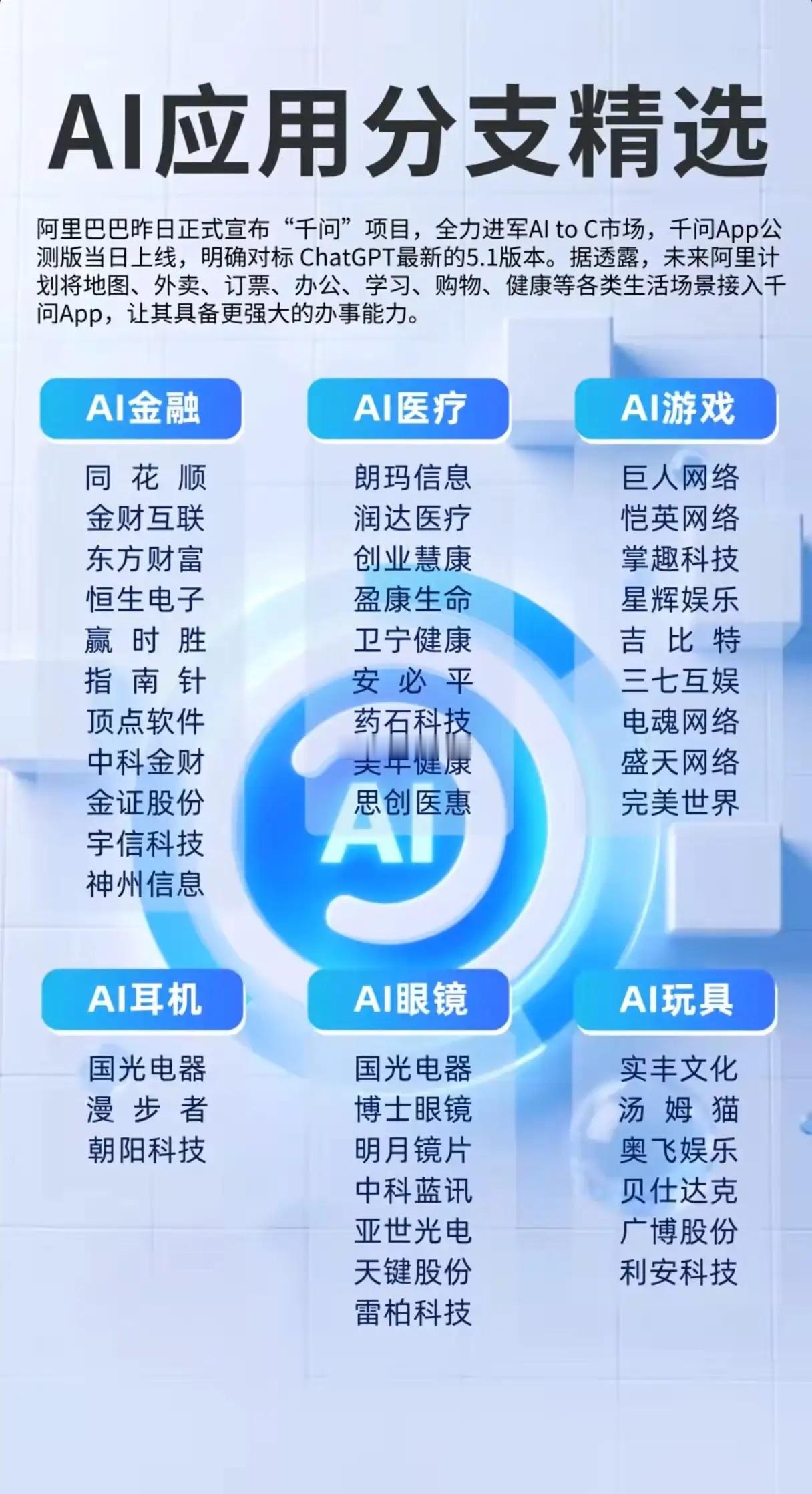

图丨Agent0 自主共演化框架。(来源:arXiv)

但这样还不够。如果只靠模型自己的知识生成和解决问题,很快就会陷入停滞,模型不可能凭空创造出超出自己理解范围的任务。研究团队的方法是引入外部工具,具体来说是一个 Python 代码解释器。

这个工具可以执行代码、进行复杂计算、验证数学结果。不仅执行智能体可以使用这个工具,课程智能体也配备了同样的能力。

这就形成了一个独特的协同进化机制。执行智能体有了代码解释器后,可以解决需要复杂计算的问题,能力边界向外扩展。这时课程智能体发现,原来能难倒执行智能体的问题现在变简单了,不确定性奖励下降。

为了维持奖励水平,课程智能体被迫生成更复杂的、需要更多工具调用的问题。研究团队在奖励函数中特意加入了工具使用频率的奖励项,进一步推动这个螺旋上升的过程。

图丨Agent0 的协同进化循环(来源:arXiv)

实验数据验证了这个机制的有效性。在三轮迭代中,课程智能体生成的任务里平均工具调用次数从 1.65 次增加到 2.60 次,任务难度也确实在上升,用第一轮的执行智能体去测试后续生成的任务,通过率从 64% 持续下降到 51%。

研究团队手工检查了生成的问题样本:第一轮的问题相对直接,比如“正方形内至少需要多少个点才能保证有两个点距离不超过 0.25 单位”;到了第三轮,问题演化为“一个满足特定递推关系的正整数序列,求第 2024 项除以 1,000 的余数”,这需要设计算法、编写代码、处理大数运算。

执行智能体的训练面临另一个挑战:没有人工标注,怎么知道答案对不对?系统采用的是多数投票机制,让执行智能体对每个问题生成 10 个答案,把得票最多的答案当作“正确答案”。

但研究团队意识到这种伪标签(pseudo-label)的可靠性参差不齐。对于执行智能体回答高度一致的简单任务,多数投票结果可信;对于回答分散的困难任务,伪标签可能就是错的。

他们为此开发了 ADPO(Ambiguity-Dynamic Policy Optimization,歧义动态策略优化)算法。这个算法的核心思路是“看菜下碟”,根据任务的歧义程度动态调整训练策略。对于高歧义任务,降低训练信号的权重,避免模型在可能错误的标签上过度学习。

同时还放宽策略更新的约束,给模型更大的探索空间。标准的强化学习算法为了稳定性会严格限制每步更新的幅度,但分析显示这种限制主要压制的是那些概率低但可能正确的答案路径,对困难任务反而不利。

执行智能体的训练还包含一个关键设计:多轮交互。不同于传统的单次输入-输出,执行代理会进行多步推理:先生成自然语言推理,识别需要计算的部分,生成 Python 代码,执行代码获得结果,将结果融入推理过程,必要时进行多轮代码调用,最终给出答案。这模拟了人类解决复杂问题时“尝试-反馈-修正”的过程。

当然,不是课程智能体生成的所有任务都适合拿来训练。系统会根据自洽性分数筛选,只保留那些执行智能体自洽性在 0.3 到 0.8 之间的任务——太简单(接近 1)学不到东西,太难(接近 0)伪标签不可靠。

在 Qwen3-8B 基础模型上的测试结果相当可观。经过三轮迭代,数学推理能力从 49.2% 提升到 58.2%,涨幅约为 18%。在 MATH(高中竞赛数学)、GSM8K(小学应用题)、2024 和 2025 年美国数学邀请赛等多个基准上,模型表现也都有稳定提升。

图丨数学推理基准的综合结果(来源:arXiv)

更重要的是这种方法所表现出的泛化能力。虽然训练聚焦在数学问题上,但模型在通用推理任务上的表现也提升了约 24%。SuperGPQA(研究生水平的跨学科问题)从 28.3% 提升到 33.0%,MMLU-Pro(多任务语言理解)从 51.8% 提升到 63.4%,BBEH(Big-Bench 困难子集)从 8.6% 提升到 13.7%。这说明通过工具辅助培养的多步推理能力确实可以迁移到其他领域。

对比其他无需外部数据的方法,Agent0 比 R-Zero 方法提升了 6.4%,相比同样使用代码执行器的 Absolute Zero 提升了 10.6%,甚至比依赖 OpenAI API 的 Socratic-Zero 还高出 3.7%。

消融实验进一步证明去掉任何一个核心组件都会导致性能下降:如果移除课程智能体的训练,性能将大幅下跌 9.3%;若不给予工具使用奖励,则下降 7.2%。

不过,团队表示这一方法更适合有明确验证标准的任务,比如数学、编程、逻辑推理。对于创意写作、风格设计这类主观性强的任务,多数投票机制就不太管用了。

而且虽然省去了人工标注,但同时训练两个 Agent、每个任务生成 10 个候选答案,计算开销也不小。框架目前依赖能提供客观反馈的工具,对纯语言推理或需要人类主观判断的任务适用性有限。

但 Agent0 展示的方向值得关注。随着 Agent 应用越来越广,轨迹数据需求会持续增长,完全依赖人工标注显然不可持续。Agent0 证明了 AI 系统可以在没有人类直接监督的情况下,通过精心设计的自我博弈和工具辅助实现能力的螺旋式上升。

目前,研究团队已经将相关代码开源。

参考资料:

相关论文:https://arxiv.org/pdf/2511.16043

项目地址:https://github.com/aiming-lab/Agent0

运营/排版:何晨龙