你们以为AI芯片的王是英伟达? 别急,谷歌已经悄悄把刀磨好了。

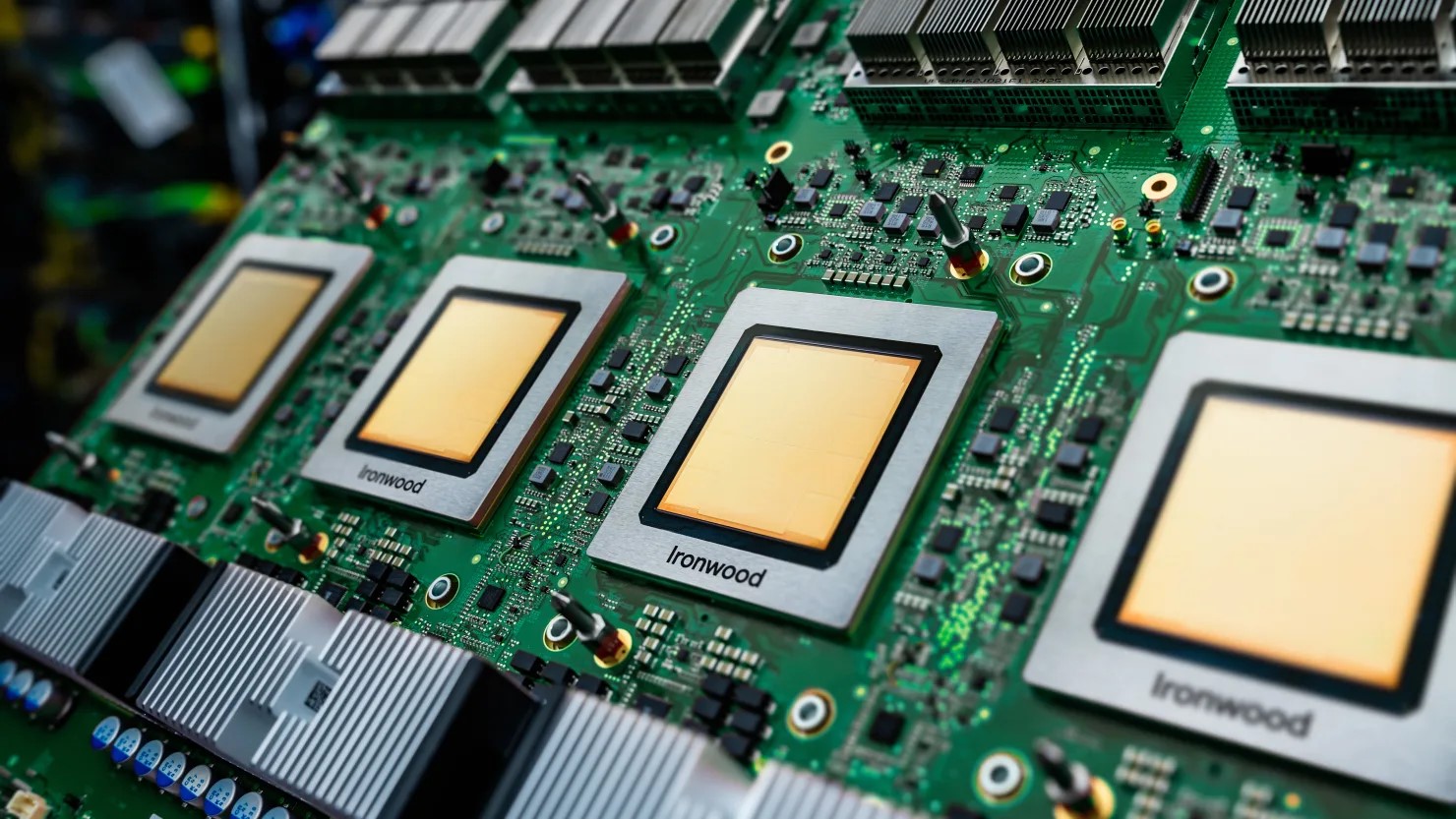

这把刀叫——TPU v7(代号Ironwood),2025年最被低估的AI核弹。

很多人以为TPU一直都“又慢又弱”,靠堆数量才勉强跟得上GPU。 这次谷歌直接把“弱”这个字撕掉了。

项目谷歌 TPU v7 (Ironwood)英伟达 B200 (Blackwell)英伟达 B300/GB200FP8算力4.6 PetaFLOPS4.5 PetaFLOPS5 PetaFLOPS显存容量192GB HBM3e192GB HBM3e288GB内存带宽7.4 TB/s8 TB/s更高芯片间互联带宽4×ICI = 9.6 TbpsNVLink 1.8 TB/s×8同左单芯片功耗比上代大幅降低1000W+更高看到了吗?单芯片性能已经和Blackwell B200打成平手,甚至在能效上完胜。 谷歌自己说:TPU v7比上一代v6e(Trillium)每瓦性能提升100%!

2. 谷歌真正的杀招:规模才是王道英伟达最牛的NVL72机架:72颗Blackwell GPU组成一个大集群。 谷歌:呵呵,小场面。

谷歌一个TPU Pod最小256颗,最大9216颗!

理论上还能再连43个Pod,接近40万颗芯片,40万!

英伟达到现在也才几万颗GPU的集群,谷歌直接玩“十万级”“四十万级”。

更离谱的是连接方式:

英伟达用昂贵的光电交换机(NVSwitch)

谷歌用光路交换机(OCS)+ 3D环面网络,省电、省钱、延迟低,还能坏了一颗自动换掉,容错拉满。

这就像英伟达在玩乐高积木,谷歌直接玩整栋楼。

因为它是个“极简主义者”。

GPU像一个全能战士:打游戏、科学计算、AI全行,但背了一身重甲。 TPU像一个只练矩阵乘法的疯子:把缓存、分支预测、纹理单元全扔了,省下来的晶体管和功耗全拿去算AI。

核心技术叫脉动阵列(Systolic Array),数据像血液一样在芯片里“哗啦啦”流一遍就出结果,基本不回内存,内存访问次数暴降,能效直接起飞。

4. 真实用户是怎么说的?Anthropic(Claude的爹)直接包了上百万颗TPU训练下一代模型

有客户实测:同样任务,8张H100的钱能买一个TPU v5e Pod,还更快

前谷歌员工爆料:对特定任务,TPU能比GPU快5倍,能效高60-65%

连黄仁勋都服气:在公开场合说“ASIC里谷歌TPU是特殊存在”

5. 那为什么大家还都用英伟达?一句话:CUDA太香了。

全球90%的AI工程师大学里学的就是CUDA

英伟达GPU在AWS、Azure、GCP、Oracle到处都有

TPU目前主要在谷歌云(不过已经在往小型云商渗透)

但风向在变: AI正在从“训练为主”转向“推理为主”,推理对CUDA依赖低得多,而对成本和能效敏感得多。 这正是TPU最擅长的主场。

6. 对普通人来说,这意味着什么?ChatGPT、Gemini以后可能会更便宜更快(谷歌自己用TPU跑推理,成本低到飞起)

谷歌云可能后来居上,摆脱“英伟达税”,毛利率重回50%+时代

英伟达不再是一家独大,芯片战争正式进入多极化时代

英伟达Blackwell = 法拉利:单车最快、最贵、最灵活、全世界都能开

谷歌TPU v7 = 高铁:单节车厢不一定比法拉利快,但拉几千节一起跑,性价比直接爆炸

未来AI算力不会只有一种赢家,而是训练用GPU + 推理用TPU的组合最香。

谷歌这张王牌,已经彻底亮出来了。 2025年,AI芯片的王座,要换人坐了?

你觉得最后谁会笑到最后?欢迎留言告诉我! 点赞+在看,下次继续拆AI芯片的台~

评论列表