字节跳动豆包最近大动作可是不少。

就在近日,字节跳动宣布,豆包大模型正式进入2.0阶段。

豆包2.0(Doubao-Seed-2.0)围绕大规模生产环境下的使用需求做了系统性优化,依托高效推理、多模态理解与复杂指令执行能力,更好地完成真实世界复杂任务。

这次的豆包2.0包括Pro、Lite、Mini三款通用Agent模型和Code模型,灵活适配各类业务场景。

据介绍,豆包2.0 Pro面向深度推理与长链路任务执行场景,全面对标GPT 5.2与Gemini 3 Pro;

Lite兼顾性能与成本,综合能力超越上一代主力模型豆包1.8;

Mini面向低时延、高并发与成本敏感场景;

Code 版(Doubao-Seed-2.0-Code)专为编程场景打造,与TRAE 结合使用效果更佳。

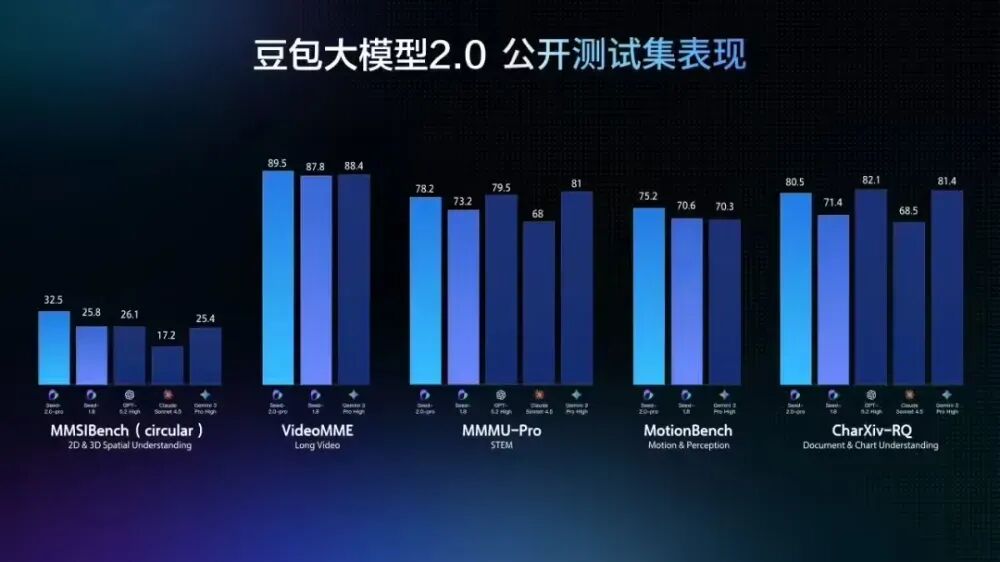

具体来看,豆包 2.0 全面升级了多模态能力,在各类视觉理解任务上均达到世界顶尖水平,视觉推理、感知能力、空间推理与长上下文理解能力表现尤为突出。

面对动态场景,豆包 2.0 强化了对时间序列与运动感知的理解能力,对“变化、动作、节奏”这类信息的捕捉更为稳定,在工程侧可用性更高。

长视频场景中,豆包2.0能作为 AI 助手完成实时视频流分析、环境感知、主动纠错与情感陪伴,实现从被动问答到主动指导的交互升级,可应用于健身、穿搭等陪伴场景。

通过加强长尾领域知识,豆包2.0 Pro在科学领域的整体成绩与Gemini 3 Pro和GPT 5.2相当。

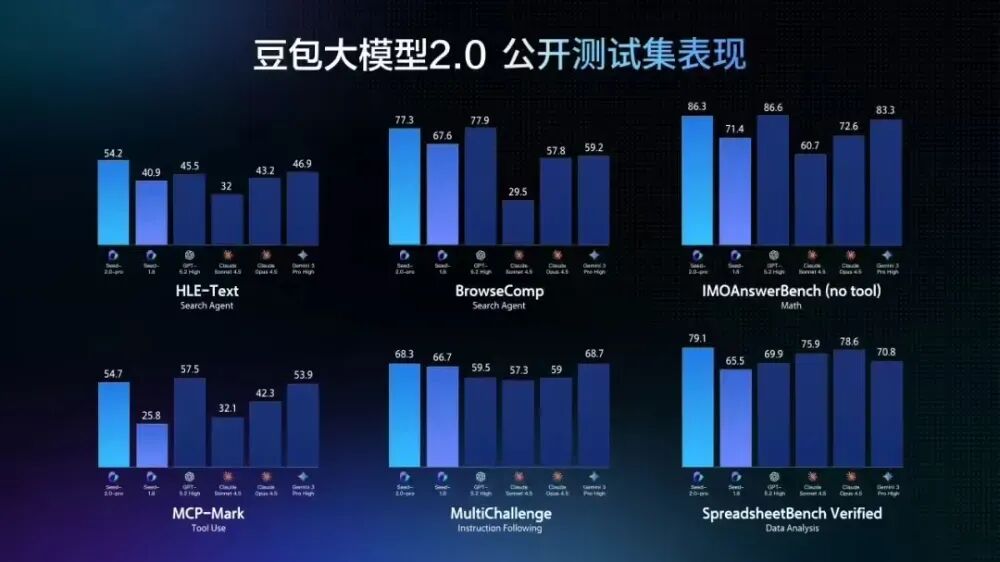

推理和Agent能力评测中,豆包 2.0 Pro 在数学和推理能力优势很大,在工具调用和指令遵循测试中也有出色表现。

豆包2.0还进一步降低了推理成本。其模型效果与业界顶尖大模型相当,但token定价降低了约一个数量级。

目前,豆包2.0 Pro已在豆包 App、电脑端和网页版上线,用户选择「专家」模式即可对话体验;豆包2.0 Code接入了AI编程产品 TRAE;面向企业和开发者,火山引擎也已上线豆包2.0系列模型API服务。

不只是豆包2.0,豆包还接入了Seedance 2.0生成模型,该模型因为生成的视频逼真且高质量,在近期引发全球关注。

Seedance 2.0模型支持原声音画同步、多镜头长叙事、多模态可控生成。输入一段提示词和参考图,就能生成带有完整原生音轨的多镜头视频内容。该模型可以自动解析叙事逻辑,生成的镜头序列在角色、光影、风格与氛围上保持高度统一。

想要体验的小伙伴,打开豆包App对话框,选择新增的“Seedance 2.0”入口,输入相关提示词,即可生成5秒或10秒视频。也可以选择“分身视频”,经过真人验证,创建自己的视频分身,体验更多创意玩法。