导读:CUDA护城河正在失效,英伟达自己比任何人都清楚这一点。收购 Groq 以及推出一系列专用芯片,并非简单的产品线扩张,而是黄仁勋在 CUDA 的旧城墙之外,被迫构建的一套全新的壁垒。算力战争的终局,将不再是单一软件生态的胜利,而是系统级成本与效率的全面胜利。

过去几年,每当讨论英伟达为何能在人工智能浪潮中占据绝对主导地位时,答案几乎总会指向 CUDA。这个并行计算平台与编程模型,经过十多年的积累,构建了一个庞大的开发者生态系统,使得任何竞争对手都难以逾越。

人们普遍认为,只要模型研究和开发还在 CUDA 上进行,英伟达的王座就稳如泰山。这种看法在过去是正确的,但现在,它正变得越来越危险和过时。

现实情况是,人工智能的消费模式正在发生根本性转变。威胁并非来自另一个试图从零开始复制 CUDA 的勇士,而是来自更高层级的软件抽象。

CUDA正在被“架空”来自 SemiAnalysis 的半导体分析师迪伦·帕特尔认为:绝大多数人工智能芯片的最终用户,将不再是那些编写底层代码的研究人员,而是直接下载开源模型和开源推理框架,然后“一键运行”的企业和开发者。

过去,研究人员需要在 PyTorch 等框架下编写代码,这些代码再被编译成 CUDA 内核在 GPU 上运行。这个过程深度绑定了 CUDA。

但现在,像 vLLM 和 SGLang 这样的开源推理引擎正在崛起。它们的作用,相当于在硬件和最终用户之间增加了一个强大的中间层。用户只需要关心模型和推理引擎,而推理引擎本身则可以被设计为支持多种硬件后端。

vLLM 已经将对 AMD GPU 的支持提升到了“一等公民”的地位,对谷歌 TPU 和亚马逊 Trainium 的支持也正在快速跟进。

这意味着,对于一个只想部署开源模型的企业来说,从英伟达 GPU 切换到 AMD GPU 的难度正在从“需要重写大量底层代码”降低到“修改几行配置文件”。

当迁移成本趋近于零时,CUDA 的软件生态锁定效应就基本消失了。

SemiAnalysis 正在运行一个名为 Inference-Max 的项目,每天在来自英伟达、AMD、谷歌、亚马逊等公司捐赠的价值数千万美元的各种 GPU 上,运行 vLLM 和 SGLang,测试不同模型在不同硬件上的性能。

一个跨硬件的、以性能和成本为导向的推理时代正在到来。

在这个新时代,CUDA 依然重要,但它更多地是作为英伟达优化自身硬件性能的工具,而不是锁定用户的壁垒。

黄仁勋的焦虑,正是源于此。当外界还在称颂 CUDA 的伟大时,他已经背后的隐患。

从“万能芯片”到“专用组合拳”英伟达对这一趋势的反应,是彻底放弃了过去“一块 GPU 包打天下”的傲慢,转向了一套复杂的、覆盖整个计算流程的“组合拳”战略。

黄仁勋害怕在特定应用场景下,竞争对手的专用芯片能在成本和性能上将他彻底击败。一旦这种“单点突破”发生,英伟达赖以为生的高额利润就无法维持。

为了应对这种威胁,英伟达开始分离推理这个看似单一的工作负载。一个典型的语言模型推理过程,可以粗略分为两个阶段:

Prefill(预填充/上下文处理):处理用户输入的全部上下文(Context),生成一个名为 KV Cache 的中间状态。这个过程计算量大,但对内存带宽要求不高。

Decode(解码/生成):基于 KV Cache,一个接一个地生成新的 token(词或字符)。这个过程是自回归的,对延迟和内存带宽极为敏感。

过去,这两个任务都由同一块通用 GPU 完成。但现在,英伟达认为这里存在巨大的优化空间。于是,我们看到了一个全新的产品矩阵:

通用 GPU (Blackwell/Rubin):继续作为训练和通用推理的主力,保持其灵活性和强大的性能。

CPX 芯片:专门为 Prefill 阶段设计。这种芯片可能拥有大量的计算单元,但配备相对廉价的内存,专门用于高效、低成本地生成 KV Cache。这类芯片也非常适合视频生成模型,因为视频模型同样是计算密集型而非内存带宽密集型。

收购 Groq 的技术:Groq 的 LPU 架构极其擅长超低延迟的 Decode。它将所有模型参数和计算单元放在片上,消除了片外内存访问的瓶颈,能够以惊人的速度生成 token 流。这对于需要实时交互的应用场景至关重要。

英伟达的打算是:用最合适的工具干最合适的活。

用户可以将一个推理任务拆分,用 CPX 处理上下文,然后将生成的 KV Cache 交给 Groq 技术的芯片进行极速解码,而这一切都由英伟达提供的系统软件无缝衔接。

通过这种方式,英伟达试图将竞争从“单一芯片性能”提升到“整个工作流的综合成本与效率”。竞争对手或许能做出一个在解码上比肩 Groq 的芯片,或者在预填充上媲美 CPX 的芯片,但很难同时提供一套完整、高效、且经过软件优化的解决方案。

这正是英伟达正在构建的新壁垒。它不再仅仅是 CUDA API,而是深入到系统架构层面的、用于管理和调度异构计算资源的复杂软件栈。

一个典型的例子是英伟达正在大力开发的 KV Cache Manager。

在多用户、长上下文、尤其是 Agent 类应用场景下,反复生成 KV Cache 的成本是巨大的。迪伦提到,对于很多代码助手应用,其大部分推理成本都花在了 Prefill 上,而不是 Decode。

英伟达的解决方案是,将不常用的 KV Cache 暂存到更便宜的 SSD 甚至内存中,在需要时再快速调回 GPU 显存。这套复杂的内存管理和调度系统,与 CUDA 编程本身关系不大,但它能实实在在地将用户的推理成本降低一个数量级。

这就是新的护城河:通过硬件组合和系统级软件,为客户提供最低的综合拥有成本(TCO)。 这比单纯的 CUDA 生态锁定要稳固得多,也难以模仿得多。

来自中国的竞争对手当英伟达在内部重塑壁垒时,外部竞争也在发生变化。最大的竞争对手来自中国。

根据半导体分析师迪伦·帕特尔观察,中国正在不计成本地试图建立一个完全垂直整合的半导体供应链。

尽管在光刻机等尖端领域仍有差距,但迪伦认为:如果全球化一夜之间消失,今天全世界唯一能够维持其半导体工厂部分运转的国家,可能只有中国。

而在这场追赶中,英伟达真正恐惧的对手不是 AMD,甚至不是谷歌,而是华为。

华为是世界上垂直整合能力最强的科技公司之一。他们在电信设备领域击败了所有西方对手,在智能手机领域一度超越苹果成为台积电的最大客户。这种系统级的工程能力、庞大的研发投入和坚韧的执行力,让任何对手都不敢小觑。

美国的制裁,客观上成为了华为和中国国产AI芯片产业的最大催化剂。由于无法购买英伟达最先进的芯片,中国的云厂商和AI公司被迫转向华为的昇腾系列芯片。

这虽然在短期内会牺牲一部分性能,但却启动了一个至关重要的正反馈循环:

第一是硬件迭代:有了真实的市场需求和大规模部署,华为的芯片可以快速迭代。

第二是软件生态:中国的开发者和开源社区会将优化重心从 CUDA 转向华为的 CANN 架构。大量的开源模型和框架会优先或专门为国产硬件进行适配。

第三是人才培养:大学和研究机构会围绕国产硬件生态培养新一代的工程师。

黄仁勋近期频繁访问中国,并努力推出符合美国规定的“特供版”芯片,其根本逻辑在于:如果英伟达完全退出中国市场,那么中国将用几年时间,硬生生打造出一个完全独立于 CUDA 的、围绕华为的AI软硬件生态。

一旦这个生态成熟,它不仅能满足中国国内的需求,还可能向“一带一路”沿线国家乃至全球输出。届时,CUDA 的全球通用性将被打破,英伟达面临的将是一个拥有全栈能力、并且成本更低的系统性竞争对手。这才是黄仁勋真正的噩梦。

AI 算力的泡沫与现实围绕着这股 AI 建设狂潮,市场上充斥着关于“资本泡沫”、“能源危机”和“耗尽水资源”的担忧。

关于资本支出泡沫,今年的 AI 基础设施资本支出将达到数千亿美金的规模,这是否不可持续?

迪伦认为,判断的关键变量只有一个:模型能力是否还在持续进步。 只要投入更多的算力还能换来更强的模型(即 Scaling Law 持续有效),那么今天的巨额投入就不是泡沫,而是必要的研发开支。这些投入所训练出的更强模型,将在未来几年创造出百亿甚至千亿美金的收入。

以 OpenAI 为例,其今年的收入有望达到 40-50 亿美金,Anthropic 紧随其后。整个行业的年化收入在今年年底可能突破 100 亿美金。只要模型进步的曲线不被拉平,这笔投资就是划算的。

关于能源危机:AI 数据中心确实是“电老虎”,美国的电网不堪重负。但解决方案并不会是许多人幻想的核能(建设周期太长,远水解不了近渴)或纯粹的可再生能源(太阳能、风能间歇性太强,无法支持7x24小时的稳定负载)。

最现实的路径将是天然气发电。数据中心将越来越多地直接在园区内建设天然气涡轮发电机,作为电网的补充甚至主力。这会推动独立发电商(IPP)和天然气相关产业的发展。

关于耗水问题:所谓“AI 正在喝光地球的水”的说法,基本属于危言耸听。迪伦认为:整个 AI 行业一年的用水量,可能还不如几个汉堡连锁店的用水量多。 数据中心的用水主要用于蒸发冷却,相比之下,农业(特别是畜牧业的饲料种植)才是真正的用水大户。生产一个汉堡所需牛肉背后消耗的水资源,可能比你和 ChatGPT 聊一整天所消耗的要多出几个数量级。这是一个典型的将次要矛盾上升为主要矛盾的认知谬误。

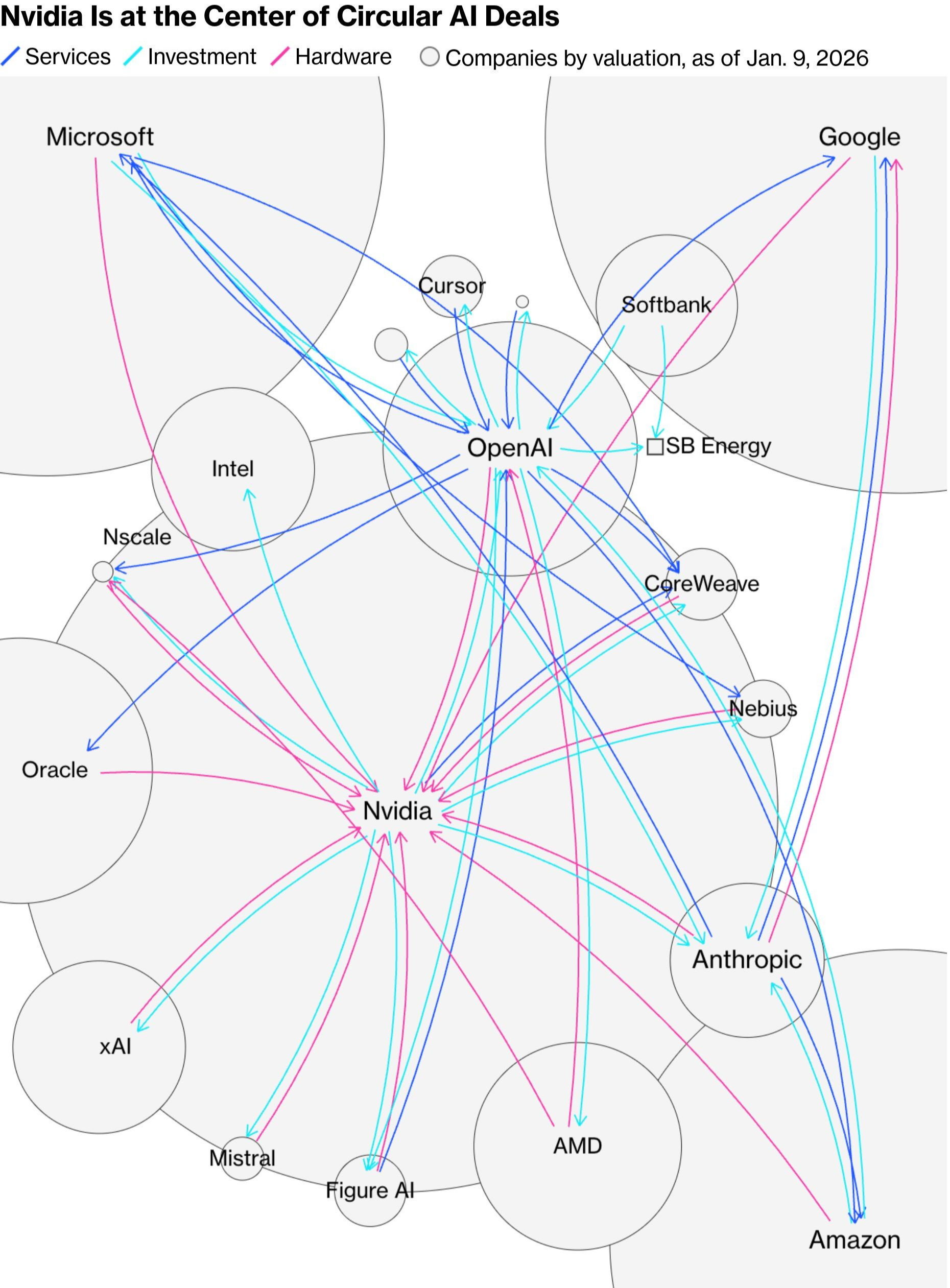

关于循环融资:市场上对英伟达投资 CoreWeave 等公司的“循环融资”模式存在担忧,认为这是一种左手倒右手的金融游戏。但其商业逻辑其实非常清晰。像 CoreWeave 这样的公司需要数百亿美金来建设数据中心,但作为初创公司,它很难获得如此巨额的贷款。

此时,由英伟达或微软这样的巨头提供债务担保或直接投资,相当于为这笔贷款进行了信用背书。这大大降低了融资难度,加速了基础设施的建设。这并非虚假的泡沫,而是在超大规模资本开支时代,为了撬动杠杆、分担风险而必然产生的金融创新。

结论:超越芯片的战争总之,英伟达的地基正在发生动摇。

黄仁勋的应对之策,是主动放弃对单一护城河的依赖,向上构建一个集异构硬件、系统软件和解决方案于一体的、以“综合成本”为核心的新型壁垒。

我们正处在一个算力军备竞赛的白热化阶段。表层是芯片与芯片的对决,中层是软件生态的博弈,而底层,则是供应链、资本和能源的全面较量。

这场战争没有简单的赢家,但其激烈碰撞所产生的巨大能量,正在以前所未有的速度,推动着人工智能本身向前发展。