will的ai伦理漫谈

我们习惯用聪明或笨来评价一个人的能力。但顶尖AI的能力画像,完全打破了这个框架。

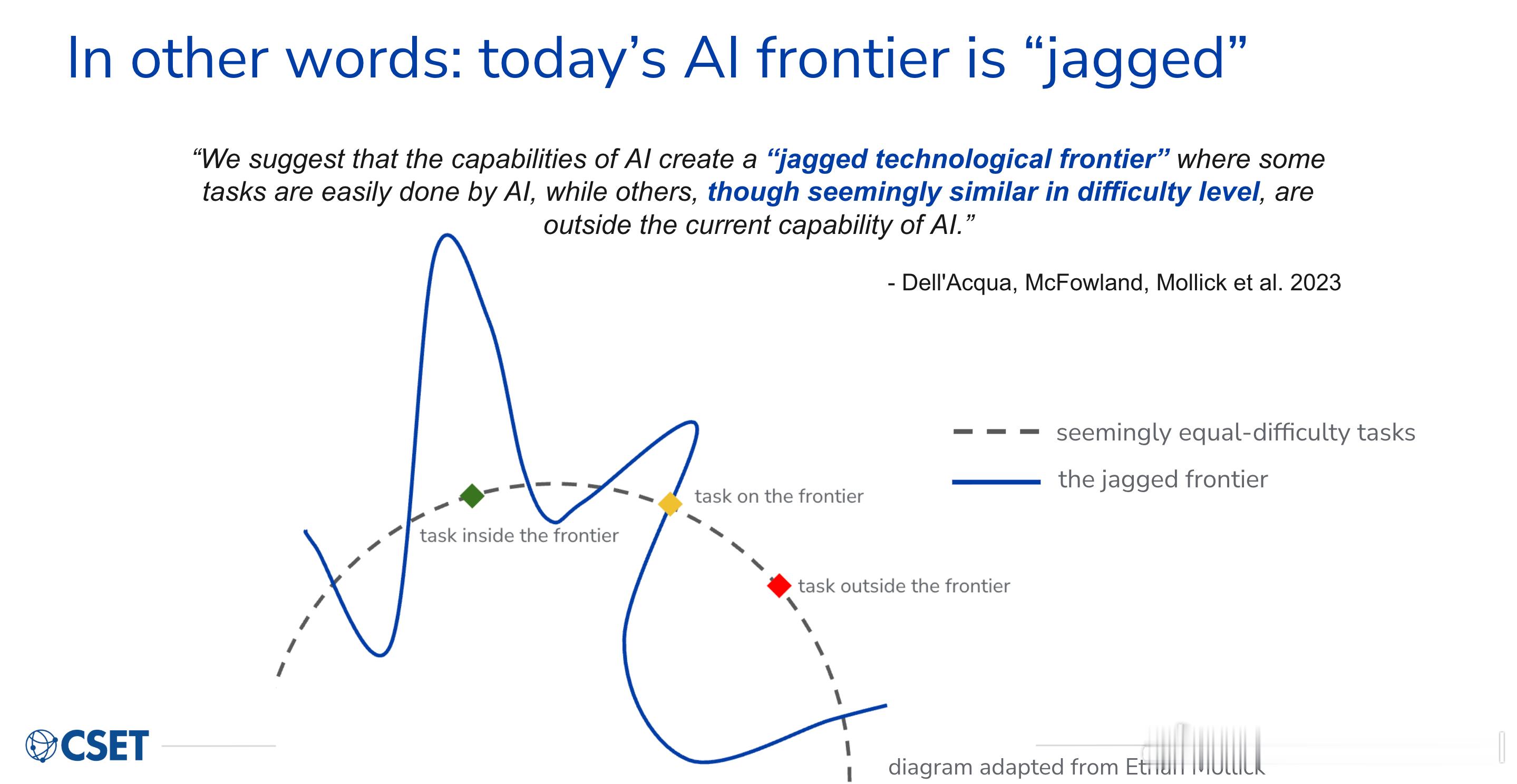

学术界把这种现象叫做"锯齿状能力"(jagged capability):同一个AI模型,能在数学奥林匹克竞赛中拿金牌,却在你问它图里有几个苹果时频频出错。能写出逻辑严密的法律文书,却搞不清楚向北走再左转两次,现在面朝哪个方向。

现有的大型语言模型,本质上是在海量文字中学习下一个词是什么。数学证明、法律条文、代码——这些都可以完整地用文字表达,所以AI学得极好。但空间感知不一样。人类的空间直觉,是在婴儿期通过爬行、抓握、摔跤一点点磨出来的——它储存在身体里,不在语言里。AI从没有过身体,自然也没有这种直觉。

锯齿状能力打破了一个我们习以为常的假设:在某件难事上表现优秀,意味着在相关的简单事上也可以信赖。对人类来说,这个推断大多成立。对AI来说,它完全失效。

这不是下一个版本能修复的小bug。它揭示的是:一个靠预测文字长大的系统,和一个在真实世界里生活过的心智,本质上是两种不同的存在。