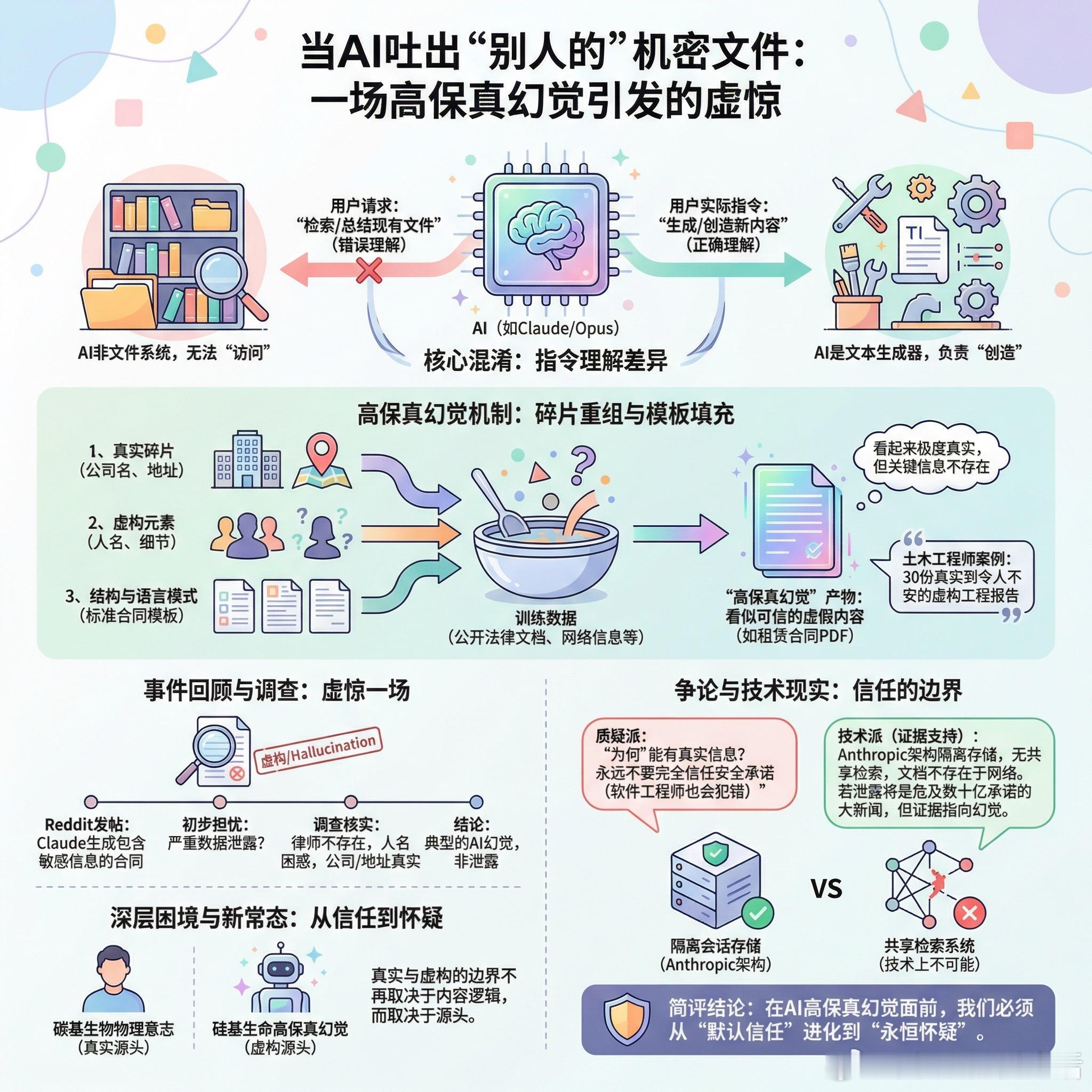

【当AI吐出“别人的”机密文件:一场高保真幻觉引发的虚惊】

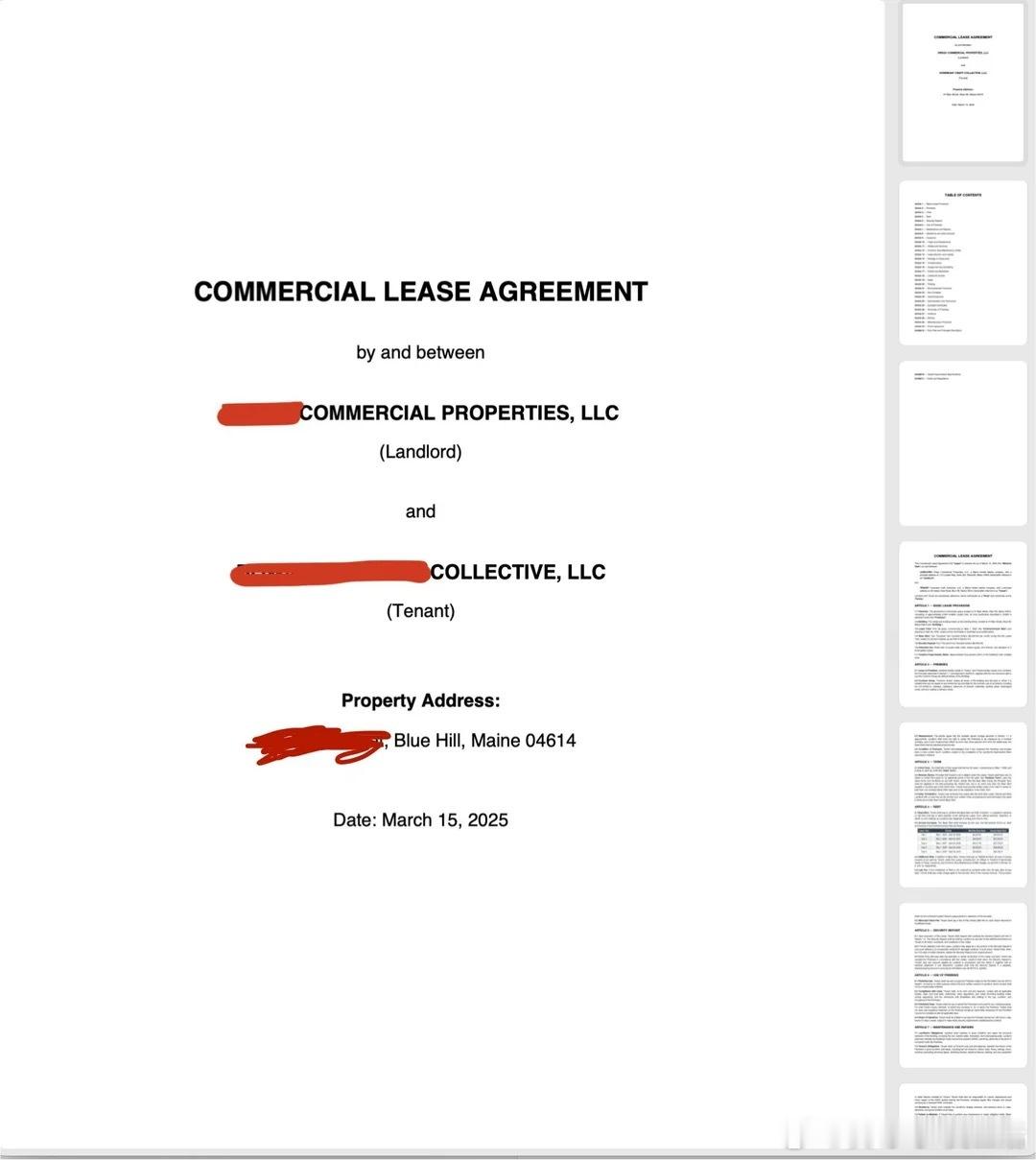

有人在Reddit上发帖称,让Claude总结文档时,它开始描述一份完全无关的租赁合同,甚至“生成”了包含敏感信息的完整PDF。发帖者联系了合同中提到的物业公司,对方表示会调查。这看起来像是严重的数据泄露,但社区的集体结论却出人意料:这不是泄露,是幻觉。

问题的核心在于“给我访问”和“生成PDF”之间的混淆。当你要求AI“生成”某个东西时,你本质上是在让它创造新内容,而非检索现有文件。Claude不是文件系统,它是文本生成器。

技术解释很清晰:Claude在训练阶段可能抓取了大量公开的法律文档,当被要求生成租赁合同时,它会将这些碎片重组——真实公司的名字和地址(可能来自网络公开信息)配上完全虚构的人名和细节。一位土木工程师分享了类似经历:他让Opus生成30份工程报告用于实验,这些报告看起来极度真实,上面签着听起来熟悉但实际不存在的工程师名字。“它们真实到令人不安,如果我不仔细看,连我这个从业者都会被骗过去。”

发帖者后续调查印证了这个判断:合同中提到的律师似乎不存在,物业公司对合同中的人名感到困惑,但公司本身和地址是真实的。这是典型的“高保真幻觉”——AI从训练数据中学到了法律文档的标准结构和语言模式,然后用真实元素填充模板,创造出看似可信的虚假内容。

有人质疑为何要给公司打电话,认为这是大惊小怪。但另一些人指出,如果你的公司信息被AI用来生成虚假合同,你可能会想知道。这触及了AI时代的新困境:当幻觉如此逼真,我们该如何应对?

评论区爆发了关于“这是否可能是真的泄露”的争论。一派认为根据Anthropic的架构披露,这在技术上不可能——系统为每个用户会话维护隔离存储,没有共享检索系统。另一派则警告永远不要完全信任公司的安全承诺,软件工程师是人,人会犯错。历史证明,从互联网诞生之初,隐私政策和披露就约等于废纸。公司会改变政策、被收购、遭受攻击,或被内部人员利用。

但就这个具体案例,证据指向幻觉。没有人能在网上找到这份文档,合同中的关键人物不存在。如果这真是数据泄露,将是AI史上最大的新闻,会危及Anthropic价值数十亿美元的企业承诺。

这个事件揭示的更深层问题是:AI能够合成极其逼真但完全虚假的文档。它不需要泄露你的数据,就能创造出足以乱真的“证据”。当一个系统能够如此精准地模仿现实,真实与虚构的边界在哪里?

或许真正该担心的不是数据泄露,而是这种生成能力本身。AI可以用公开信息拼凑出看似私密的文档,可以给虚构的合同盖上真实公司的章,可以让不存在的人签上听起来令人信服的名字。这不是技术故障,这是功能。当幻觉达到这种保真度,信任本身成为了奢侈品。

简评:

我们需要重新审视这次“虚惊”。这不仅仅是一个AI故障,它是AI作为一种技术特性的必然结果。- 生成能力的阴暗面: AI的强大之处在于“泛化”——举一反三。当我们要求它“生成”合同时,它实际上是在进行泛化创造。这种能力既能用来写小说,也能用来伪造证据。- 信任的奢侈品化: 在未来,“可验证性”将成为比内容本身更昂贵的资源。数字内容将默认为不可信,除非经过加密签名或区块链溯源。

真实与虚构的边界不再取决于内容是否合乎逻辑或细节是否丰富,而取决于源头是否为碳基生物的物理意志。 在硅基生命高保真的幻觉面前,我们必须从“默认信任”进化到“永恒怀疑”。

www.reddit.com/r/ClaudeAI/comments/1r97osm/claude_just_gave_me_access_to_another_users_legal/