9B端侧开源模型跑通百万上下文,面壁全新稀疏-线性混合注意力

最强的大模型,已经把scaling卷到了一个新维度:百万级上下文。

几天前,Claude Opus 4.6发布,让人第一次真切感受到了百万上下文的涌现能力——

单次吃进50万字中文内容、实现跨文档法律分析、多轮Agent规划……

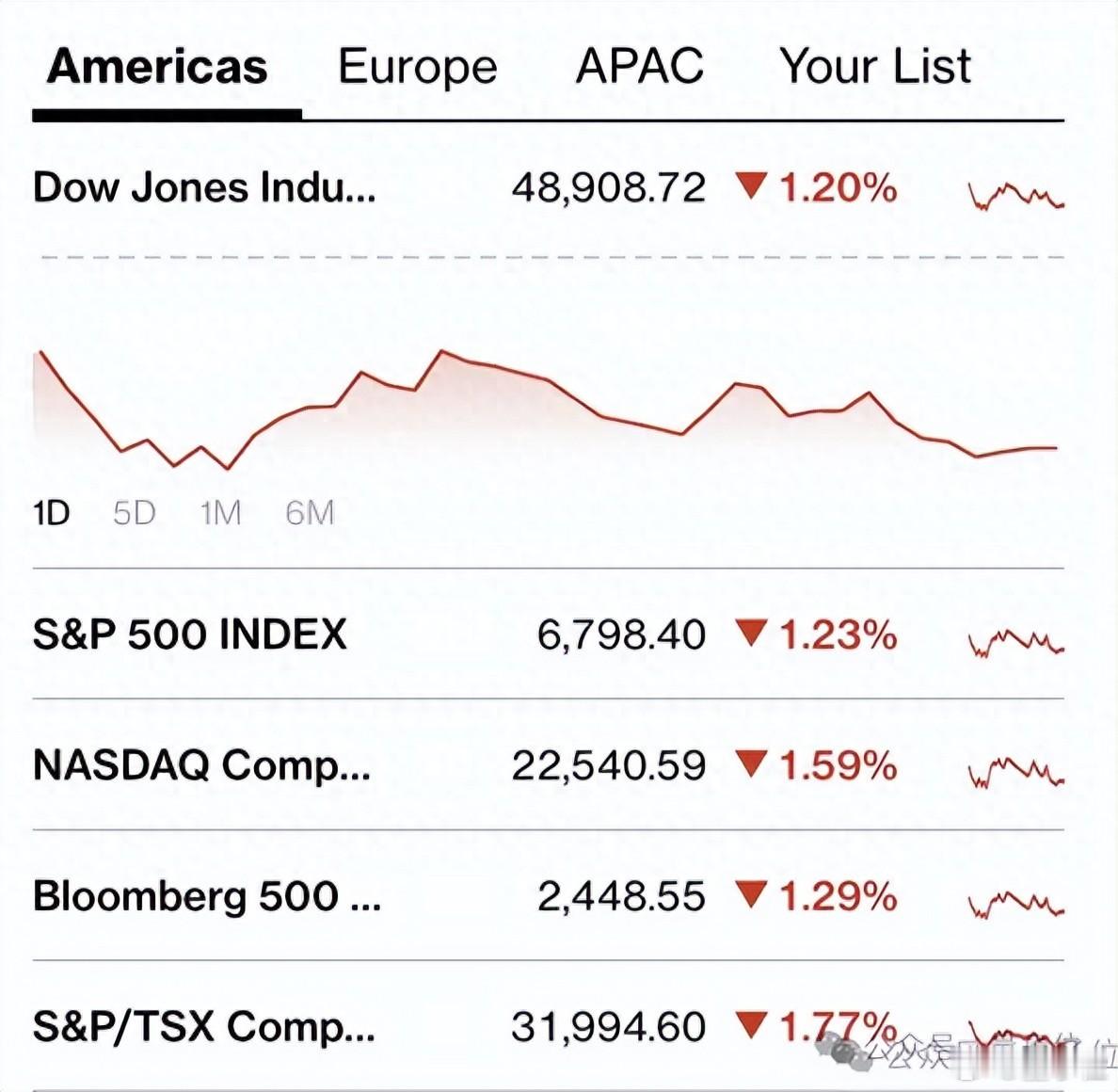

此情此景,用户火速用脚投票,华尔街更是直接给出K线回应。

而这股scaling的风,也很快吹到了端侧。

刚刚,面壁智能带着首次大规模训练的稀疏与线性混合注意力模型,小年交卷——

这套新注意力架构,不仅解决了传统Transformer的计算冗余,还第一次在性能无损的前提下,让9B端侧模型能够在5090显卡上处理百万长文本。

与此同时,基于SALA注意力架构的模型MiniCPM-SALA也将一并开源。

除此之外,面壁还以OpenBMB社区名义,联合SGLang与NVIDIA发起2026稀疏算子加速大奖赛(SOAR),将这套scaling能力直接交到开发者手中,推动端侧Agent部署的性能突破。网页链接